中國所謂的AR領頭羊Rokid,跟Apple Vision Pro產品差距有多大?快訊

最近被瘋搶的Apple Vision Pro 屬于外觀滑雪鏡形態以VST模擬AR功能的VR頭顯,簡單說就是用攝像頭“透視”的VR。即使對于蘋果,基于光學透視OST的AR都堪稱圣杯。

文章來源:aR星人

懂行的人知道AR比VR難10倍不止!最近被瘋搶的Apple Vision Pro 屬于外觀滑雪鏡形態以VST模擬AR功能的VR頭顯,簡單說就是用攝像頭“透視”的VR。即使對于蘋果,基于光學透視OST的AR都堪稱圣杯。

一個動不動拿到大額融資的國內AR創企,所謂中國AR領域的“領頭羊”,之前最早做語音識別、智能音箱,創始人散發著滿滿的geek氣息。在許多先行者包括巨頭微軟Hololens和Magic Leap都幾年拿不出一款新品、時不時被傳團隊解散,國內相關企業如影創倒閉甚至創始人因融資糾紛有牢獄之災,AR企業幾乎集體揭不開鍋的時候,Rokid的風光讓人疑竇叢生。

【作者】李沛霖

【編輯】aR星人

AR的直觀理解

Rokid的AR和Apple Vision的AR截然不同,很難歸類為同一類產品。但兩家都瞄準著挖掘消費電子AR頭顯的金礦。

相比電視機的大屏幕 、PC的中屏幕、手機的小屏幕,如果你眼前的三維空間成為一個新的“窗口”,現實世界的“實物“全部可以虛擬、任意塑造、增強,戴上一副眼鏡或頭顯能夠實現眼前空間的徹底數字化,對于生活和工作完全是顛覆。

我們見證過iPhone風靡全球,它真正發明了智能手機,如今跟工作和生活息息相關,出門手機低電量甚至會帶來生存焦慮。同樣道理,未來我們可能也離不開下一代AR消費電子,即“空間個人計算機“。

要理解AR,要知道先行一步的VR本質上是一個什么東西。就像你看3D電影,VR眼鏡類似電影幕布整個“包裹”住你眼睛,你看到的完全是計算機生成的視覺信息,沉浸其中。戴上VR眼鏡會讓視覺和外界處于物理斷聯的狀態,因為VR要隔絕外部光線要打造沉浸,現實里完全隔絕外部視線是危險的,VR要拓展到工作和生活場景,必須要實現對周圍環境的感知。VST,即Video See Through,就是VR眼鏡感知外部的解決方案,高清攝像頭和相應的視頻流處理單元即對應的VST硬件。

AR與之不同的是,它一般是OST,即Optic See Through,它在物理形態上不遮擋外部光線,不追求完全沉浸,用戶看到的是外部環境光和計算機生成的圖像的疊加。AR可以設計成沉浸或不沉浸,類似電鍍調光技術還可以隨意調整環境光透過率,當外部進入的環境光降低到0,就變成了類似VR。

直觀理解,VR追求沉浸在物理設計上隔絕了眼睛能直接看到外部光線,必須借助VST。AR是相對“透明”設計,它允許一部分或絕大部份光線穿過光學鏡片進入眼睛。

蘋果Vision Pro所演示的VST路線

庫克之前對AR的興奮完全出于真情流露。收購供應鏈新銳創企、關鍵軟硬件默默自研、等待基礎技術進步和成熟,蘋果在推出Vision Pro之前不知道蟄伏了多久,Vision Pro也被期待是下一個iPhone時刻。

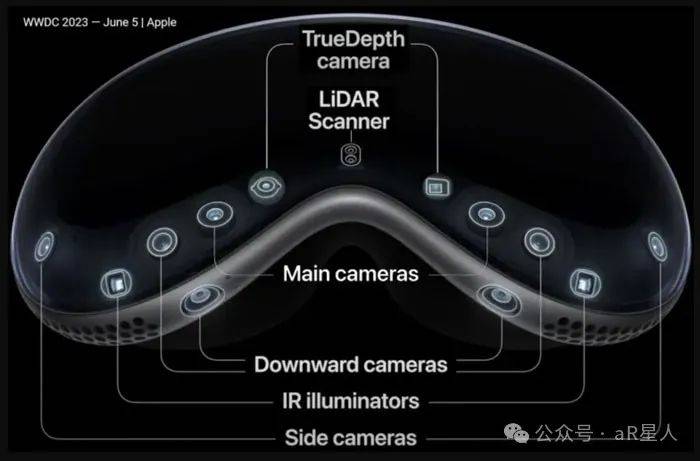

從終端硬件上看,Apple Vision Pro 的核心處理器M2、專用傳感器數據實時處理器R1、高度定制的類Pancake的3片式透鏡,來源于多年自研和收購前沿技術公司,并且做了深度整合。數量龐大的多種類傳感器,包括用于眼球追蹤的紅外相機、三維空間感知和建模的LiDar Camera和深度相機、前向和側向覆蓋多個角度的高清RGB攝像頭,帶來的眼球追蹤+裸手手勢+語音交互,從硬件到算法上的調教一出場就站在行業的頂峰,真實效果震撼了許多人。Vision Pro在VR頭顯的易用性、使用頻率和可能的場景擴張上蘊藏巨大潛力。

Vision Pro 所演示的Eyesight功能,覆蓋著玻璃罩的曲面OLED多角度格柵式顯示,基于深度學習的臉部建模和數字頭像(表情)傳遞,外部動態的智能化提醒和切換,讓佩戴頭顯的用戶自然且巧妙地感知外界信息。相比之下,以往佩戴VR頭顯的用戶和其他人幾乎無法正常“交流”,人與人之間的視覺割裂,陷入信息孤島,環境安全和友好幾乎是無法解決的問題。

三言兩語很難完全講清Vision Pro的領先究竟在哪個層次。相比來自Meta、字節Pico的已有同類產品,有些媒體將Vision Pro的領先概括為“硬件堆料“,顯得淺薄且可笑。蘋果公司對用戶需求的理解,產品形態和人機交互“規范定義”的拉力,富有魔力的營銷和對用戶體驗的拿捏,這種自帶的扭曲現實力場讓Vision Pro被迅速搶購一空。可以預見,我們很快就可以看到競品在功能上“跟進”,外觀上借鑒,甚至直接粗暴抄襲。

Vision Pro可以說充分外顯了蘋果領先時代的產品哲學和創造底蘊。風口之下的另一邊,在中國所謂的AR企業領頭羊,被媒體描繪為“一杯酒融一個億“的Rokid,今年上半年推出了Rokid Max折返式光路BirdBath原理的AR眼鏡,這種幾乎只有顯示功能的OST AR眼鏡,產品原理和售價相比Vision Pro差別巨大。

Rokid在國內資本市場被追捧據說源于這家公司的“人機交互”基因,但強大的硬件是應用、操作系統和完整生態的基礎載體,沒有一個成熟且達到一定滲透和使用率的硬件終端,Rokid頻繁舉辦的開發者活動、對于自研空間操作的宣傳,不知道支點在哪。基礎邏輯可以說完全不通。

Rokid 相比同行如已經倒閉的影創,同樣做BirdBath AR眼鏡、經常參與國外專業技術組織研討和展覽活動的Xreal,以及TCL孵化的、同時推進兩條產品線的雷鳥創新,包括BirdBath AR眼鏡以及全彩顯示Micro LED搭配光波導OST的AR眼鏡,Rokid身上的疑點簡直不要太多。

Apple Vision Pro對比Rokid Max,究竟有怎樣的差別?

首先,產品原理。VR/AR頭顯的產品原理其實并無本質區隔,它們都可以概括為:由計算機生成的圖像經過光學調整,在非常近的距離讓眼睛對焦。

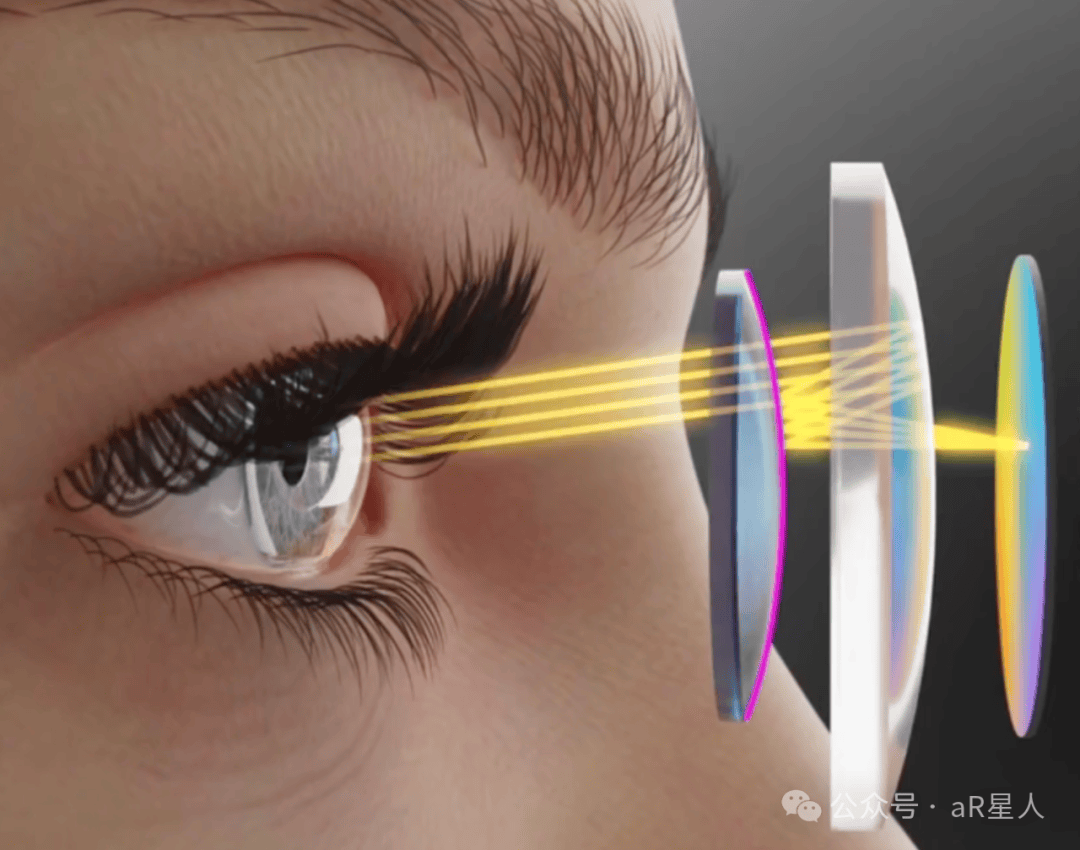

當計算機實時生成的圖像在一小塊“顯示屏“上出發,圖像光源經過透鏡放大,在設計好的光路中傳輸,實現超短距離的對焦,再進入瞳孔,我們就看到了虛擬圖像。AR與之基本類似,不同的是,AR的小屏幕并不像VR一般放在眼睛前方,因為這樣會遮擋外部視線,它一般設計在不遮擋視線的頂部鏡架或側部鏡腿位置。AR生成的虛擬圖像經過光路,會和外部真實光線一起進入眼睛。

Apple Vision Pro所使用的多透鏡Pancake折疊放大光路,圖像光源來自眼睛前方的微顯示屏

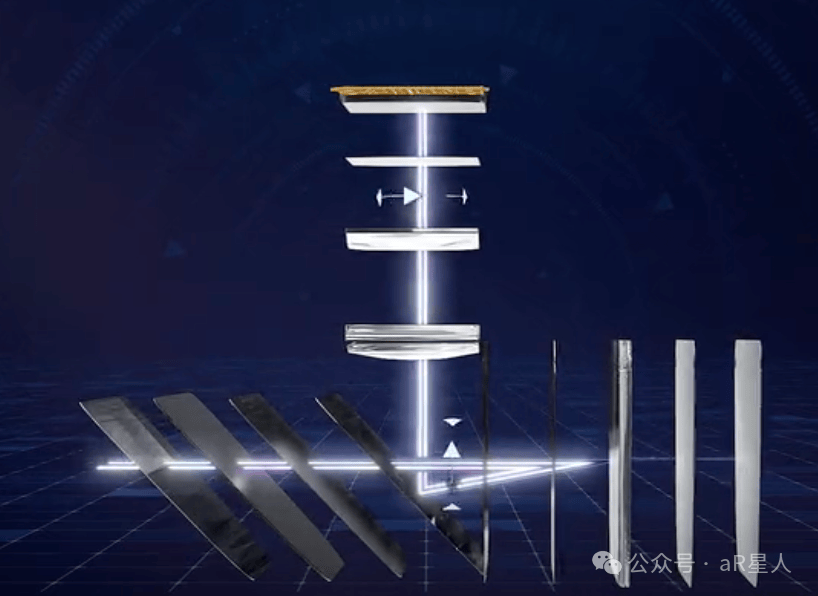

BirdBath原理AR眼鏡,圖像光源來自頂部微顯示屏(示意圖來自鴻蟻光電公司)

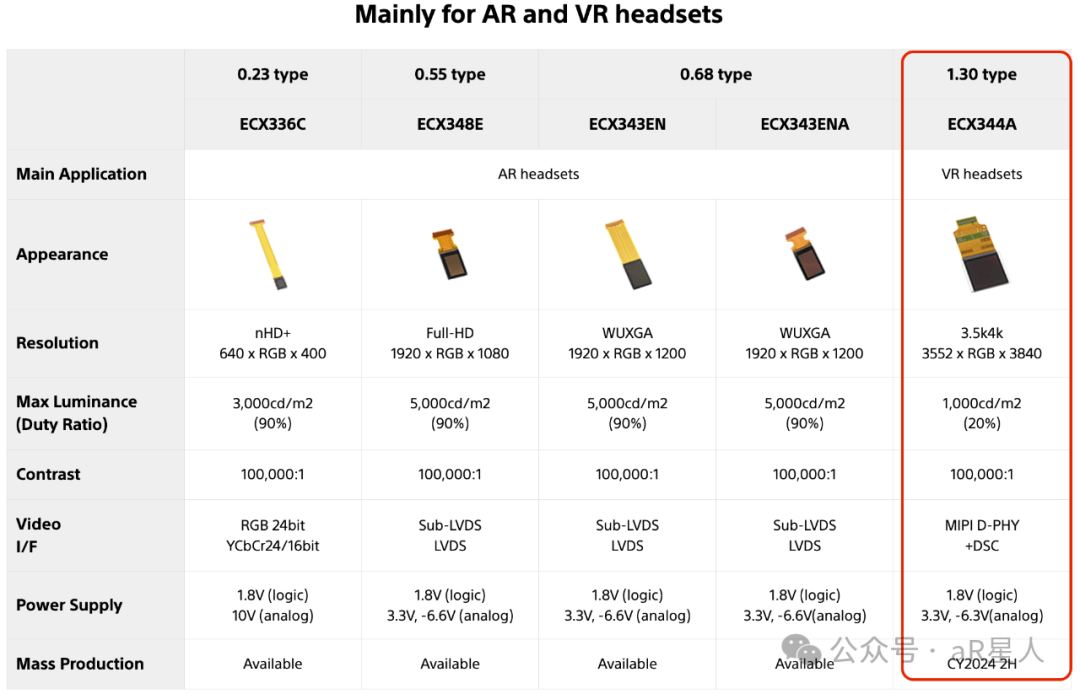

第一個關鍵對比,生成圖像的“小屏幕”。這塊小屏幕分辨率必須足夠高,還需要非常高的亮度,因為不同的光學模組光效率大相徑庭,要保證一定的入眼亮度,以及豐富的的色彩、對比度,低耗電等。迄今為止最佳的解決方案是硅基OLED屏幕,即硅芯片驅動的超密集OLED微型“顯示器”,索尼已經實現指甲蓋大小的面積上實現4K分辨率的硅基OLED小屏幕。多家科技巨頭還在研發Micro LED,不過Micro LED目前無法在一塊硅基板上同時實現RGB三色超高亮度顯示。

微顯示屏作為新興顯示產業,終端品牌都需要從供應鏈廠商采購。Apple Vision Pro使用了2塊索尼4K分辨率的OLED微顯示屏作為內屏,一塊異形柔性屏AMOLED作為前向eyesight顯示(外屏),后續傳言還會將視涯和京東方加入供應鏈。微顯示屏需要在分辨率、色彩、功耗、成本上不斷進化,頭顯的“空間分辨率”對于提升產品體驗至關重要,面板巨頭主導著技術進步和批量生產良品率。

之前媒體流傳的BOM清單顯示,售價3499美元的Apple Vision Pro硬件物料成本約 1509 美元,其中,索尼供應的兩片4K分辨率OLED內屏一片350美元,合計 700 美元,幾乎占據了物料成本的一半,為成本最高的零組件。相比之下,臺積電代工的M2 處理器僅需 120 美元。

2023年年中發布的Apple Vison Pro,采用了4K分辨率的昂貴OLED微顯示屏,(型號可能是官網顯示的1.30type ECX344A),相比2023年上半年發布Rokid Max,還停留在1080P分辨率。

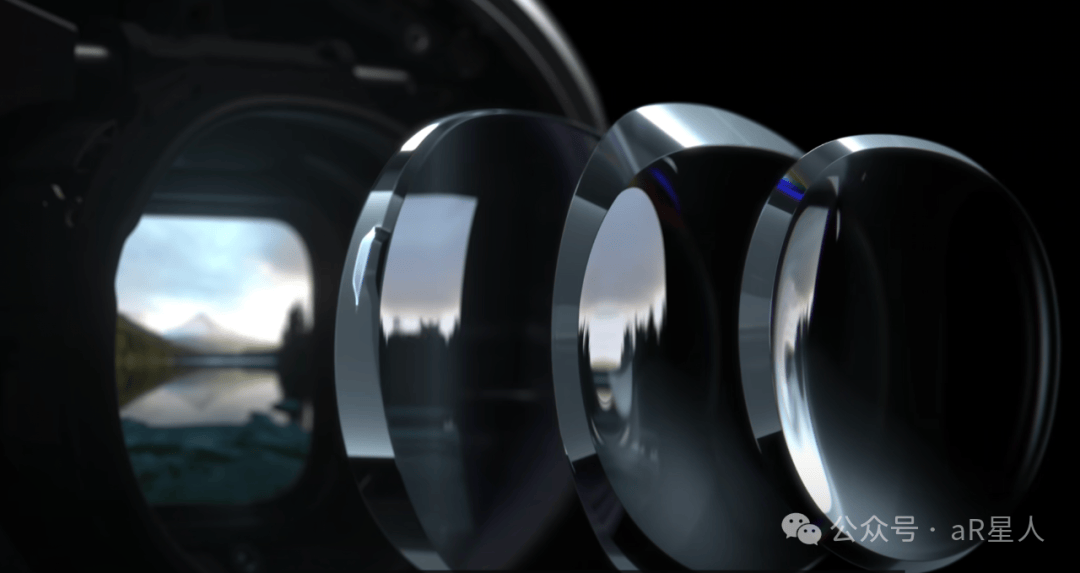

第二個關鍵對比,光路傳輸,即光學顯示透鏡的設計,VR頭顯一般有透鏡、涅菲爾透鏡、Pancake透鏡模組三種方案。它們之前的差異就是模組輕薄程度(關鍵)和一系列影響顯示效果的光學特性,如FOV、光效率、MTF、雜散光抑制、像差和色差消除、超高分辨率適配等。Pancake最為輕薄,關鍵光學參數綜合最好,但也是近乎10倍于傳統透鏡的價格。

根據多方信源,Apple Vision Pro采用了定制的多片式(3片)Pancake透鏡模組。蘋果官方新聞稿中明確提到“定制的折反射透鏡”字樣,Pancake屬于折返射透鏡的其中一類,蘋果已收購的光學公司Limbak就以折反射方案聞名,此前還推出了某種“超級Pancake”透鏡設計。

熟悉光學透鏡設計和制造的人知道,Pancake本身就是一個剛出來沒幾年的前沿高端方案,適配超高分辨率屏幕的Pancake模組,(根據同行HyperVision解析)Vision Pro使用的還是多片式帶有獨特非標曲面的定制Pancake模組,這意味著對齊、加工精度和量產一致性是個非常大的挑戰。透鏡模組的設計,分光、極化偏振、消除鬼影的各類光學鍍膜和層片需要有非常深厚的光學研究和積累。

Apple Vision足夠獨創且研究艱深,構筑了一定的產品壁壘,頭顯整體的精密和復雜從光學透鏡一個組件上就能體現。相比之下,中國的AR廠商如Rokid Max似乎還是用中國供應鏈廠商的整體BirdBath模組方案。惠牛、鴻蟻或視涯,直接拿來用。

嚴格地說,Apple Vision Pro這種不同原理的復雜頭顯、完全不同的產品形態,Rokid不應該拿來對比。但同類型的BirdBath AR眼鏡,Xreal 能夠獨立設計光引擎+透鏡模組,并且在無錫有光引擎組件的量產工廠,這也是Xreal能夠在國外專業技術組織SID Display VR/AR專場頻頻亮相的原因。因為即便BirdBath,也有PBS偏振分光棱鏡,消除多源頭的雜散光、邊緣炫光、矯正像差和色差的鍍膜,設計光路、適眼距、eyebox、改進MTF等諸多細節。

Rokid即使相比雷鳥創新,雷鳥的BirdBath產品線也是拿來主義,但起碼雷鳥毫不畏懼另一條產品線Micro LED+光波導方案“真AR眼鏡”的技術困難。雷鳥創新雖然直接使用了來自JBD的Micro LED的X-cube RGB三塊小面板方案,但成功落地量產,解決了配套的研發、測試、量產一致性的諸多問題。

沒有從底層產品原理上最細微處的洞察,對光學的積累和重視,沒有完全從0到1的獨創精神,是無法做出真正領先市場的AR硬件終端。

第三個關鍵對比,傳感、數據傳輸&處理、人機交互和人機工程對于視覺-人腦的深入研究,這是當前技術研發能夠拉開差距的關鍵地方。光學顯示透鏡和小屏幕都有比較成熟的供應鏈廠商,昂貴或便宜,好的不好的,大家可以選擇。即使蘋果、Meta、谷歌近10年收購的光學和微顯示領域的研究型創企,也基本上處在實驗室的超前概念預研階段,能真正落地整合進自家產品且商用的很少。體驗做不到超前的獨一檔。

VR跟裹住眼睛的3D幕布不同的是,VR需要能跟外界進行交互,比如手勢交互、眼球運動、頭部運動、肢體體感、指環或手柄。實現交互的硬件基礎,設計專門的高精度傳感器,比如基于dToF原理的激光雷達、基于紅外點陣特征識別的深度相機、高清RGB攝像頭,以及相匹配的先進算法。傳感器的數量、分布、精度、算法的效果會有明顯差異。

以Apple Vision Pro為例,它將眼球追蹤+手勢交互+語音操作做到了極致,并且將其引導成“空間計算”最舒服最符合直覺的交互模式。為此,Apple Vision Pro在傳感器的硬件配置和算法上下了非同一般的功夫,比如為了實現高精度的眼球追蹤,別家都是左右眼各一個紅外相機和數個IR LED等,Apple Vision Pro 左右眼各兩個IR Camera+環繞眼眶更多的 IR LED。已經公開的專利也顯示,蘋果在視網膜透視、特征識別上進行了大量的研究,為了進一步提升精度,甚至有工業級的激光干涉測量原理的方案被披露出來。

Vision Pro 配備了 4 個定制的紅外相機(左右眼各 2 個),使用多達 34 顆紅外 LED 燈,可以非常精準的追蹤和預測眼球視線的變化,凝視和掃視。數據傳輸和處理上,Vison Pro 同時搭載了 M2 和全新的 R1 芯片,M2是桌面級性能非常強大的核心處理器,而R1 芯片是蘋果為 vision pro 設計的傳感器數據實時處理定制芯片,類似iPhone協處理器,是其實現高性能眼動追蹤重要基礎。R1 芯片專門處理 12 個攝像頭、5 個傳感器和 6 個麥克風的輸入,以確保內容實時呈現在用戶眼前,R1 芯片能在 12 毫秒內將新圖像傳輸到顯示屏中,降低圖像到屏幕的延遲,以超高的精度、極低的延遲識別用戶所在的環境以及用戶的手勢和眼球的運動,精準分析出需要渲染的場景,從而實現動態注視點渲染功能。通過 Vision Pro 提供的低延遲、高精度信息輸入,用戶得以從手柄控制器中解放出來,只需眼睛注視即可準確地選中元素,以極其自然、優雅且直觀的方式與數字世界進行交互。

Vision Pro讓眼球追蹤真正落地成為主要交互方式,還是令一眾觀察家驚訝不已。

微軟HoloLens 2軟件開發指南中曾提到,人眼視線的運動是不規則且跳躍的,并且速度很快。可能在用戶完成點擊動作之前,視線早已經飄走,因此將快速眼睛凝視信號與慢速的控制輸入結合起來需要格外小心。

此前Meta Reality Labs的一份關于“手柄、頭動以及眼動交互”的一份研究指出,以90Hz運行的平均精度誤差低于1°的眼動追蹤系統(在無光標或其他反饋的條件下),它在易用性、采用率和疲勞度相較于頭部輸入(Head input )分別提高了66.4%、89.8%和116.1%,而相較于手柄輸入則分別降低了4.2%、8.9% 和 116.1%,不過它的失誤率是三者當中最高的。

除了強大的傳感器和實時數據處理,在算法方面,蘋果也早早進行了布局。根據外部資料,早在2017年,蘋果收購德國眼動追蹤技術開發商SensoMotoric Instruments(SMI),這是一家專注于該細分領域的頭部企業,已有30余年的發展歷史。

蘋果前員工Sterling Crispin爆料稱,蘋果圍繞Vision Pro有一個專門研究神經技術的開發小組,而他所做的工作之一是通過AI預判用戶的操作行為。他提到,“你的瞳孔會在你點擊某物之前作出反應,部分原因在于用戶對接下來發生的事有所期望。因此,可以通過觀察用戶的眼睛行為并配合實時反饋的UI來增強用戶大腦的預測性瞳孔反應,從而創建生物反饋。” AI算法的加入,是Vision Pro的眼動交互備受好評的重要原因之一。

眼球追蹤只是蘋果Vision Pro在人機交互體驗高出同行一截的顯性部分。在傳感、數據傳輸、計算、人機交互軟硬件方案上,亮點實在是太多。

比如在AR/VR剛興起時,業內就幾乎確認了裸手交互是重點方向,只是要想做好手勢交互精準且流暢,技術難度不小。而裸手交互被蘋果真正推向了極致,展現了與市場上其他玩家完全不同的策略。Vision Pro配備了多個用于手勢識別的攝像頭和傳感器,可以檢測腰部以下的手勢,用戶還可以把手放在膝蓋上進行操作,這是之前VR廠商做不到的。

主流VR的手勢追蹤必須將手放在攝像頭FOV范圍內,使用時雙手必須微抬或舉在身體前面,時間一長就非常累,導致用戶體驗差。而Vision Pro則擁有6顆SLAM+手勢攝像頭,其中有兩顆向下的攝像頭專門捕捉手垂放在腿上的視角。另外,還有兩顆斜向下的攝像頭同時兼顧SLAM和手勢。甚至為了弱光環境下手勢識別準確性,蘋果還加入了兩顆紅外LED進行輔助。

這種垂直視角的攝像頭,專門用于捕捉大部分時間、不抬手的時候的手勢,因為很多時候雙手應該自然垂放在腿或桌子上,符合人體工學邏輯。蘋果Vision Pro是AR/VR中的首家采用這一方案的設備,屬于獨一份。

Apple Vision Pro 眼球追蹤體驗刷新了行業認知,多種類型傳感器硬件、分布、算法研究之深很難給出準確評估,硬件底層還有專門的傳感器數據實時處理芯片R1,極限壓縮交互上的反饋(圖像)延遲,Apple Vision Pro在人機交互的軟硬件的方方面面,幾乎獨創了整個方案。其他廠商短時間幾乎沒有可能追趕得上。

更值得深度思考的是Eyesight。根據Vision Pro官方發布會的說法,Eyesight是一項引進先進AI后才解決了某項一直阻礙團隊重要難題的交互方案,它完全不同于傳統VR的產品視角,少有人知曉的細節:Eyesight的硬件實現,讓外部攝像頭傳感器位置偏離常規,相應的矯正算法增加了不少的設計困難。

為了Eyesight,Vision Pro多用了一塊復雜的曲面OLED外屏,增加了曲面玻璃罩的“死重“,為此還需要重新調整傳感器分布,進行實時畫面矯正,代價不小。蘋果也在發布會上花了很大篇幅講Eyesight。

國外著名的AR專家Karl Guttag在個人博客上暗示,蘋果在VR頭顯上擊中了關鍵點,深思熟慮后為了Eyesight 在產品上做了重大妥協,體現了這家公司對產品和用戶的深刻洞察力:Eyesight做到了外圍視覺的動態感知,佩戴頭顯的用戶能夠真正融入日常環境,與他人更符合人類的方式互動,讓VR頭顯開始真正具備大眾消費電子產品的可能。基本可以預見,Eyesight 馬上也會成為行業的“高端標配”。

再回過頭來看,中國的AR創企代表Rokid,有位參加Rokid首屆高校XR內容創作大賽的選手在媒體上這樣寫道,

Rokid Max Pro,這款眼鏡從外觀和手感/重量上其實與Rokid Max基本沒有什么區別,就是兩眼中間位置增加了一個攝像頭。而利用這個攝像頭以及另一款目前還不能公布的硬件,Rokid Max Pro用戶能實現SLAM( 即Simultaneous Localization And Mapping視覺定位和建圖)、3D裸手交互等功能。嗯,我相信你一定見過同類產品上利用雙目視覺實現該功能的產品,但Rokid Max Pro卻只用單目,這效果真的OK么?我現在不能透露有關它的一些技術細節,但我可以說的是這款產品在定位的“穩定性”以及手勢動作識別“精確度”、“延遲性”上的表現令我驚嘆....

還在糾結和對比單目還是雙目的視覺SLAM...傳感器的精度、數據的延遲、數據流的處理模式、有沒有專屬芯片和定制傳感器這種底層創新暫且不表,產品宣傳如此高調,“空間計算操作系統”、“超前的應用開發生態”、“人機交互重大創新”、“AR空間創作工具“,投資人是真不懂嗎?

如此簡陋,毫無技術含量的供應鏈組裝品,卻成為中國AR企業的代表,融資如喝水一般簡單,不禁莞爾一笑。底層創新是如此之難。但你剛挖好農村宅基地的地基,卻要在這上面壘起來上海中心大廈?

這一波風口,飛上天之后,總該拿出點硬貨。我不信投資人真的不懂Apple Vision Pro的創新有多么深刻。在歷時兩個月的深入研究后,我相信真正的創業者應該出發了。

1.TMT觀察網遵循行業規范,任何轉載的稿件都會明確標注作者和來源;

2.TMT觀察網的原創文章,請轉載時務必注明文章作者和"來源:TMT觀察網",不尊重原創的行為TMT觀察網或將追究責任;

3.作者投稿可能會經TMT觀察網編輯修改或補充。