OpenAI發布新模型GPT-4o,記者實測來了!快訊

我們使用GPT-4o來描述圖片,并讓其分別對一張中文圖表和一張英文圖表進行了分析,GPT-4o的文本和圖片功能自推出之日起就向ChatGPT推送。

【TechWeb】5月14日消息,今日凌晨,OpenAI正式發布了新一代的旗艦模型GPT-4o,可以利用語音、視頻和文本信息進行實時推理。

據介紹,GPT-4o在英文文本和代碼中的表現與GPT-4 Turbo相當,但在非英文文本上的能力大幅提升,在視頻和音頻的理解上,GPT-4o要明顯強于當前的其他模型。

此外,能力更全面的GPT-4o,響應速度也更快,最快232毫秒響應音頻輸入,平均響應時間為320毫秒,與人類在對話中的響應速度相當。

除了更強、更全面的能力,OpenAI也在推動GPT-4o更廣泛的應用。GPT-4o的文本和圖片功能自推出之日起就向ChatGPT推送,ChatGPT用戶可免費使用,ChatGPT Plus用戶的數據量上限將是免費用戶的5倍,新版本的音頻模式將在未來幾周向ChatGPT Plus用戶推送。

TechWeb記者第一時間對GPT-4o進行了實測,不過目前免費用戶還不能使用圖片生成功能。我們使用GPT-4o來描述圖片,并讓其分別對一張中文圖表和一張英文圖表進行了分析,來看看結果。

我們首先讓GPT-4o描述了一張圖片,發現描述的非常準確,并可以對單獨人物的動作進行描述,最后還可以用文字來分析該圖片場景。

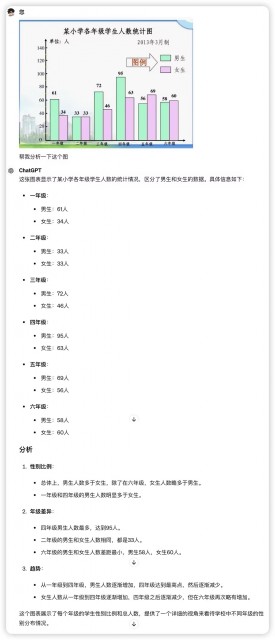

隨后是一張中文圖表,不但可以讀懂上面的數字含義,還可以對差異和趨勢進行非常詳細的分析。

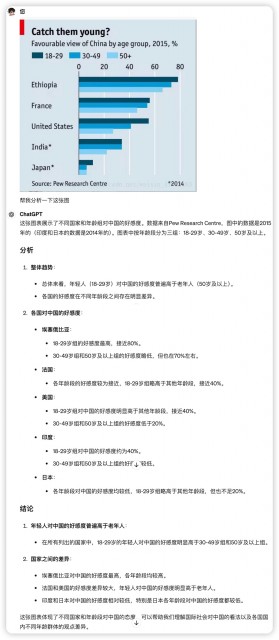

最后是一張英文圖表,GPT-4o可以讀懂并翻譯圖表展示的數據內容,最后根據圖表數據總結得出分析結論。

總體來說,GPT-4o的能力的確有了很大的提升,未來在所有功能開放的時候,TechWeb也將繼續為大家帶來更詳細的實測體驗。(蕭健)

1.TMT觀察網遵循行業規范,任何轉載的稿件都會明確標注作者和來源;

2.TMT觀察網的原創文章,請轉載時務必注明文章作者和"來源:TMT觀察網",不尊重原創的行為TMT觀察網或將追究責任;

3.作者投稿可能會經TMT觀察網編輯修改或補充。