OpenAI再度拉響安全警報:又一高層離職揭示巨大風險快訊

盡管OpenAI擁有多個安全團隊,格姐的離職是OpenAI安全團隊內部動蕩的一部分,OpenAI最近面臨了安全團隊成員的連續離職。

OpenAI最近面臨了安全團隊成員的連續離職,其中包括AI策略研究員Gretchen Krueger(簡稱格姐)。她在2019年加入OpenAI,參與了GPT-4和DALL·E2的開發,并在2020年領導了OpenAI第一個全公司范圍的“紅隊”測試。現在,她也成為了發出警告的離職員工之一。

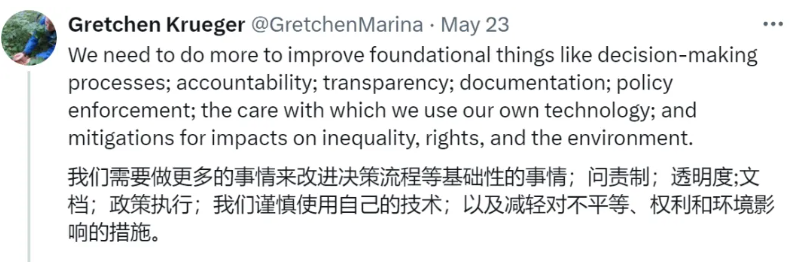

格姐在社交媒體上表達了她的擔憂,認為OpenAI在決策流程、問責制、透明度、文檔、策略執行等方面需要改進,并應采取措施減輕技術對社會不平等、權利和環境的影響。她提到,科技公司有時會通過制造分裂來剝奪那些尋求追究責任的人的權力,她非常關心防止這種情況發生。

格姐的離職是OpenAI安全團隊內部動蕩的一部分。在她之前,OpenAI首席科學家Ilya Sutskever和超級對齊負責人Jan Leike也已經宣布離職。這些離職事件引發了外界對OpenAI安全問題決策過程的質疑。

OpenAI的安全團隊主要分為三大塊:

超級對齊團隊:專注于控制還不存在的超級智能。

Safety Systems團隊:專注于減少現有模型和產品的濫用。

Preparedness團隊:繪制前沿模型的新興風險。

盡管OpenAI擁有多個安全團隊,但風險評估的最終決策權仍然掌握在領導層手中。董事會擁有推翻決策的權利,目前董事會成員包括了來自不同領域的專家和高管。

格姐的離職和她的公開言論,以及OpenAI安全團隊的其他變動,引起了社區對AI安全性和公司治理的廣泛關注。這些問題現在對人們和社區都很重要,它們影響著未來的各個方面如何以及由誰來規劃。

1.TMT觀察網遵循行業規范,任何轉載的稿件都會明確標注作者和來源;

2.TMT觀察網的原創文章,請轉載時務必注明文章作者和"來源:TMT觀察網",不尊重原創的行為TMT觀察網或將追究責任;

3.作者投稿可能會經TMT觀察網編輯修改或補充。